手游排行榜爬虫怎么弄

爬虫基础概念解析

数据抓取技术,即网络爬虫,是一种通过自动化程序从网站上提取信息的工具。在手游行业,爬虫技术被广泛应用于收集应用商店的排名数据、用户评价、下载量等信息,为市场分析提供支持。实现一个手游排行榜爬虫需要掌握HTTP协议基础、HTML解析、数据存储等技术。爬虫的核心流程包括目标网站分析、请求发送、数据解析和存储。针对手游排行榜,需要特别关注动态加载内容的处理,以及反爬虫机制的应对。

选择合适的开发语言

开发爬虫可以选择多种编程语言,每种语言都有其优缺点。Python凭借丰富的库支持,成为最受欢迎的选择。以下是几种主流语言的对比:

Python:适合快速开发,有BeautifulSoup、Scrapy等强大库支持

Java:适合大规模系统,性能稳定但开发周期较长

JavaScript:适合爬取JavaScript渲染的页面,Node.js生态完善

Python因其简洁的语法和强大的第三方库,成为本文的推荐语言。开发环境建议使用Anaconda,它集成了Python解释器和常用的数据分析库。

爬虫开发工具准备

在开始编码前,需要准备以下开发工具:

1. 代码编辑器:推荐Visual Studio Code,支持多种语言和插件

2. 版本控制:Git是行业标准,用于代码管理和协作

3. 测试工具:Postman用于测试HTTP请求,Chrome DevTools用于分析网页结构

4. 反反爬虫工具:代理池和User-Agent管理器是必备

开发环境配置包括安装Python、设置虚拟环境、安装必要的库。建议使用pip3安装requests、BeautifulSoup4、lxml等核心库。

目标网站分析技巧

爬取手游排行榜前,必须仔细分析目标网站。以下是分析步骤:

1. 访问排行榜页面,观察URL结构

2. 使用浏览器开发者工具检查网络请求

3. 识别数据加载方式(API或动态渲染)

4. 分析反爬虫机制(验证码、Token等)

以某应用商店排行榜为例,通常排行榜数据通过API接口返回,接口地址可能包含分页参数、排序参数等。动态加载的页面则需要分析JavaScript执行逻辑,找到数据源。

请求发送与处理

发送HTTP请求是爬虫的基础环节。Python的requests库提供了简洁的API。以下是基本操作示例:

```python

import requests

url = "https://example.com/api/rankings"

headers = {

"User-Agent": "Mozilla/5.0 ..."

}

params = {

"page": 1,

"sort": "downloads"

}

response = requests.get(url, headers=headers, params=params)

data = response.json()

```

处理HTTP响应时,需要检查状态码和内容类型。常见的响应处理包括:

301/302重定向处理

HTTP错误处理(404/500等)

内容编码解码(gzip/brotli等)

请求超时设置

HTML解析方法

获取网页内容后,需要解析HTML以提取数据。以下是两种主流解析方法:

1. DOM解析:使用BeautifulSoup或lxml解析HTML树结构

```python

from bs4 import BeautifulSoup

soup = BeautifulSoup(html_content, 'lxml')

titles = soup.select('.ranking-item .title')

```

2. XPath解析:适用于结构复杂的网页

```python

from lxml import etree

tree = etree.HTML(html_content)

titles = tree.xpath('//div[@class="ranking-item"]/h3/text()')

```

解析技巧包括:

使用CSS选择器定位元素

处理嵌套结构

提取属性值(src、href等)

清理空白字符和特殊符号

动态内容处理策略

现代网站普遍使用JavaScript动态加载内容,爬取这类网站需要特殊处理。以下是解决方案:

1. 使用Selenium模拟浏览器行为

```python

from selenium import webdriver

driver = webdriver.Chrome()

driver.get(url)

html = driver.page_source

```

2. 分析网络请求,直接爬取API数据

```python

假设发现API地址为 /api/data

response = requests.get("https://example.com/api/data", headers=headers)

```

3. 使用Pyppeteer处理Chrome环境

```python

import pyppeteer

browser = await pyppeteer.launch()

page = await browser.newPage()

await page.goto(url)

html = await page.content()

```

反爬虫机制应对

网站通常会采取措施阻止爬虫访问,常见机制包括:

1. User-Agent检测

使用代理池轮换IP

设置随机User-Agent

2. 验证码处理

使用OCR工具识别验证码

第三方验证码服务

3. Token验证

分析Token生成逻辑

使用会话保持登录状态

4. 行为检测

模拟人类操作(鼠标移动)

设置合理的请求间隔

数据存储方案设计

爬取到的数据需要有效存储,常见方案包括:

1. 文件存储

CSV:简单易用,适合小数据量

```python

import csv

with open('rankings.csv', 'w', newline='') as file:

writer = csv.writer(file)

writer.writerow(['rank', 'title', 'downloads'])

writer.writerows(data)

```

JSON:适合嵌套数据

```python

import json

with open('rankings.json', 'w') as file:

json.dump(data, file, indent=2)

```

2. 数据库存储

SQLite:轻量级,适合单机应用

MySQL/PostgreSQL:适合分布式系统

3. NoSQL存储

MongoDB:适合文档型数据

数据存储时需考虑:

索引设计

数据去重

字段映射

存储优化

爬虫自动化与定时任务

为了持续获取最新数据,需要实现自动化和定时任务。以下是实现方法:

1. 使用Python的schedule库

```python

import schedule

import time

def crawl():

爬虫逻辑

pass

schedule.every().day.at("10:00").do(crawl)

while True:

schedule.run_pending()

time.sleep(1)

```

2. 使用操作系统的定时任务

Linux: crontab

Windows: Task Scheduler

3. 云服务定时任务

阿里云定时任务

AWS Lambda+EventBridge

爬虫日志与监控

完善的日志和监控系统能帮助定位问题。以下是实现建议:

1. 日志记录

使用logging库设置不同级别

```python

import logging

logging.basicConfig(filename='crawler.log', level=logging.INFO)

logging.info("Crawling page 1")

```

2. 监控指标

请求成功率

耗时统计

错误类型

3. 异常告警

邮件通知

短信提醒

遵守法律与道德规范

爬虫开发必须遵守法律法规和道德规范:

1. 服务器压力控制

设置请求间隔

限制并发数

2. 数据使用限制

遵守robots.txt协议

不抓取禁止内容

3. 数据隐私保护

避免抓取个人敏感信息

合理使用数据

4. 知识产权尊重

不抓取受版权保护的内容

标注数据来源

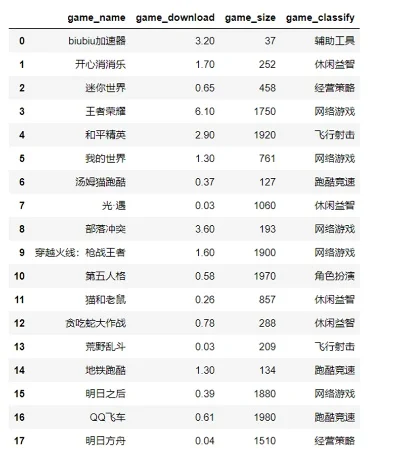

实际案例演示

以爬取某应用商店手游排行榜为例,以下是完整流程:

1. 分析发现排行榜通过API加载,URL为:

```

https://api.gamestore.com/v1/rankings?category=mobile&sort=popularity

```

2. 编写爬虫代码:

```python

import requests

import time

def fetch_rankings(page=1):

url = f"https://api.gamestore.com/v1/rankings"

params = {

"category": "mobile",

"sort": "popularity",

"page": page,

"limit": 50

}

headers = {

"User-Agent": "GameRankingCrawler/1.0"

}

response = requests.get(url, headers=headers, params=params)

if response.status_code == 200:

return response.json()

else:

time.sleep(5) 重试

return fetch_rankings(page)

rankings = []

for page in range(1, 5): 爬取前4页

rankings.extend(fetch_rankings(page))

保存为CSV

import csv

with open('game_rankings.csv', 'w', newline='') as file:

writer = csv.writer(file)

writer.writerow(['rank', 'title', 'downloads', 'rating', 'url'])

for item in rankings:

writer.writerow([

item['rank'],

item['title'],

item['downloads'],

item['rating'],

item['url']

])

```

3. 定时运行:

```python

import schedule

import time

def daily_crawl():

print("Starting daily crawl...")

fetch_rankings()

print("Crawl completed.")

schedule.every().day.at("03:00").do(daily_crawl)

while True:

schedule.run_pending()

time.sleep(10)

```

优化与扩展建议

爬虫开发是一个持续优化的过程,以下建议有助于提升爬虫质量:

1. 性能优化

使用异步库(aiohttp)

多线程/多进程

数据缓存

2. 功能扩展

支持多个平台

增加数据分析功能

整合第三方数据

3. 可维护性

模块化设计

配置化管理

自动化测试

4. 安全防护

请求伪装

错误处理

重试机制

小编总结

开发手游排行榜爬虫需要综合运用网络编程、数据解析、自动化等多方面技术。通过合理规划开发流程,选择合适的工具和技术,可以构建高效稳定的爬虫系统。同时,必须遵守法律法规和道德规范,确保爬虫行为的正当性。随着技术的不断发展,爬虫开发也需要持续学习和适应新的挑战,才能保持其价值。